相关传送门:线性代数复习,大语言模型。

综述

线性回归

线性模型(Linear Model):已知训练数据 (xi,yi),学一个向量 w 使得预测函数为 f(x)=w0+wTx。

线性回归(Linear Regression):用均方误差(Mean Squared Error)估价,即 Jn=n1∑(yi−f(xi))2。

X=[x1,x2,…,xn],Y=[y1,y2,…,yn]Jn(w)=(Y−XTw)T(Y−XTw)∇Jn=−2X(Y−XTw)∇Jn=0↔w^=(XXT)−1XY

推论:如果样本数小于特征数,XXT 一定不满秩,即推不出最优解。

拓展:为什么用均方误差估价是合理的?

- 一个线性模型的实际效果记为 y=f(x,w)+ϵ,样本量充足时噪声 ϵ 服从高斯分布 N(0,σ2)。

- 如果我们已经有了个模型,那么当前标签分布出现的概率是 L=i=1∏nP(yi∣xi,wi,σ)。

- 我们希望找到一个模型使得 L 尽可能得大,用最大似然理论去估计,得出极大化 L 等价于极小化 MSE。

logL=−2σ21∑(y−f(x,w)2)+c(σ)

拓展:使用 λ∣w∣q 惩罚项来缓解标准线性回归中的过拟合和多重共线性的现象。当 q=1,2,3… 时优化函数是凸的,所以我们总能解出最优的解(即使是数值解)。但是当 q=0.5 时就没有那么好的性质了。

岭回归(Ridge Regression):特指 q=2 的 L2 惩罚项。解的系数会向零收缩,但不会完全变为零。

J’n=i=1∑n(yi−xiTw)2+λi=1∑pwj2∇Jn′=−2X(Y−XTw)+2λw∇Jn=0↔w^=(XXT+λI)−1XY

套索算法(LASSO):特指 q=1 的 L1 惩罚项。解会变得稀疏的,即很多维会被压缩到 0。

逻辑回归:

贝叶斯决策理论

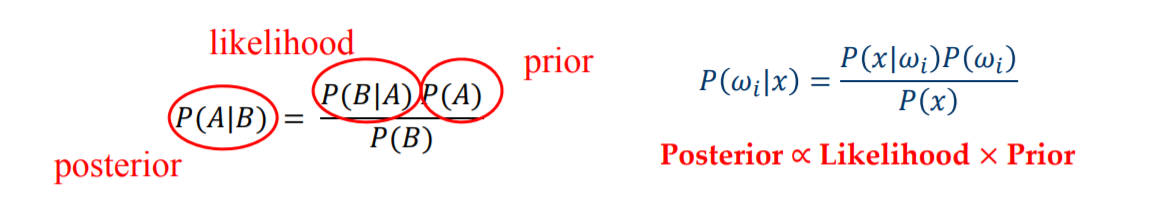

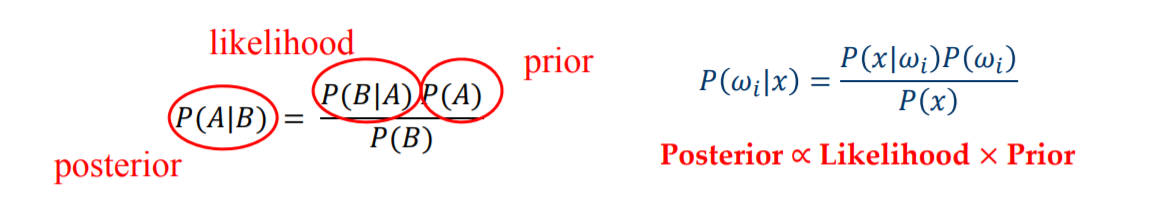

贝叶斯决策理论(Bayesian Decision Theory):基于贝叶斯公式进行有监督地预测。

- 先验(Prior):P(wi)。获得新数据前,基于历史经验或知识对事件发生概率的初始信念。

- 似然函数(Likelihood):P(x∣wi)。在已知某个参数或状态的情况下,观察到新数据的概率。

- 后验(Posterior):P(wi∣x)。观察到新数据后,对事件发生概率的最新、最完整的信念。

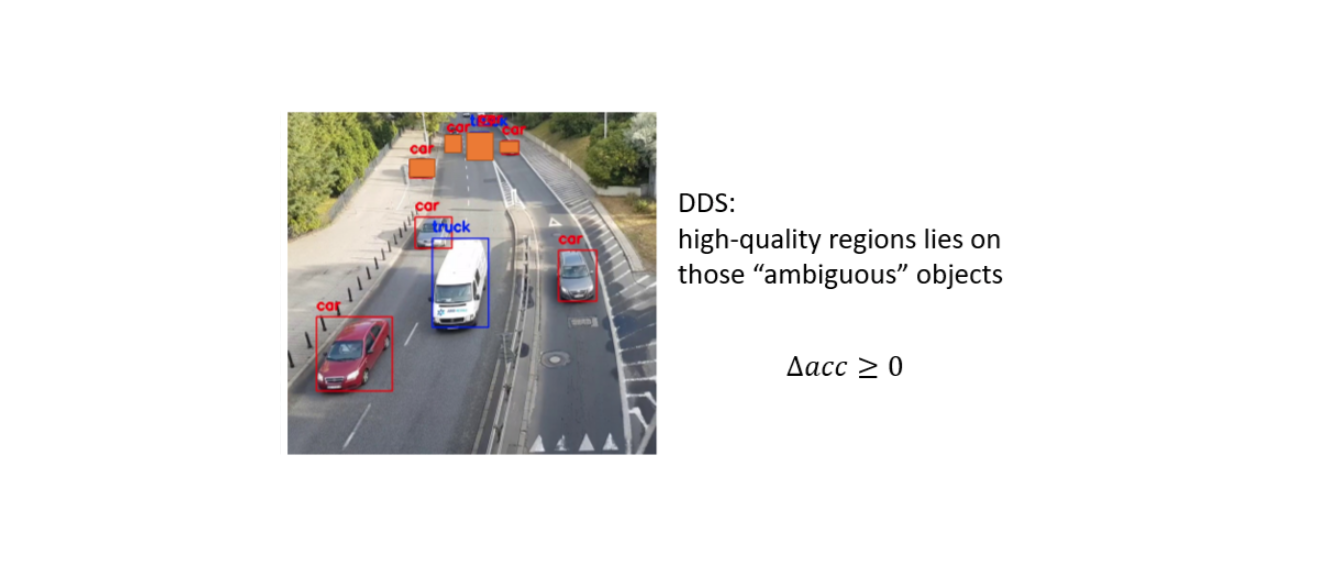

最大似然决策(Maximum Likelihood Decision):直接根据 Likelihood 去预测标签。

- 隐含了所有类别的先验概率相同,即 P(w1)=P(w2)=⋯=P(wn)。

最优贝叶斯决策(Optimal Bayes Decision Rule):用更准确的 Posterior 去预测标签,理论最优。

【待更新推导】

聚类