这是 Professor Bo Li 推荐我的一篇 paper,有关 Adversarial Attacks 的内容,Arxiv 传送门。

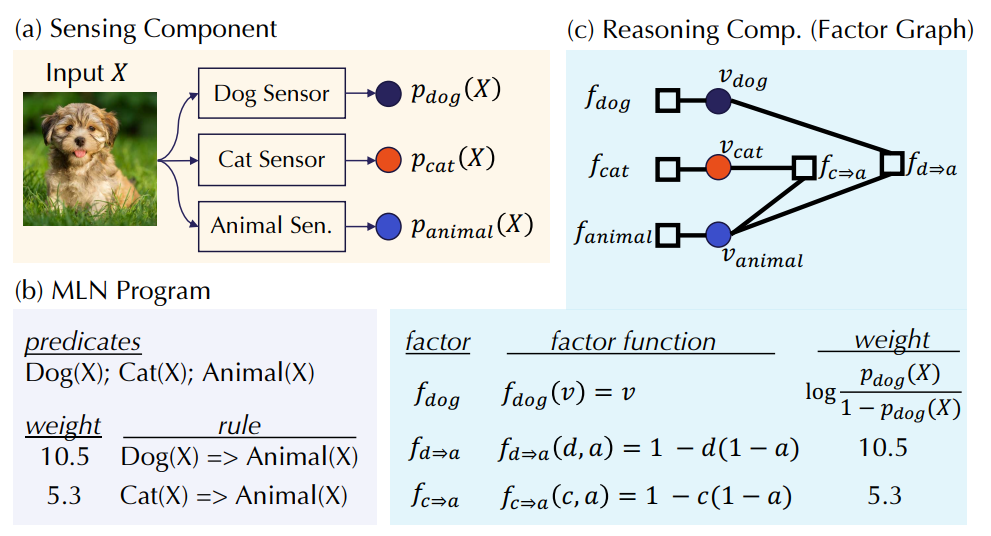

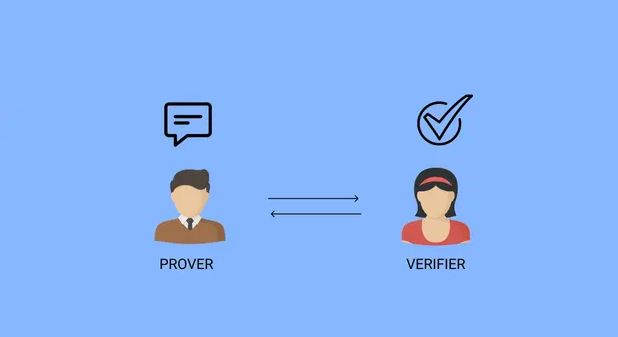

什么是 Sensing-Reasoning pipelines

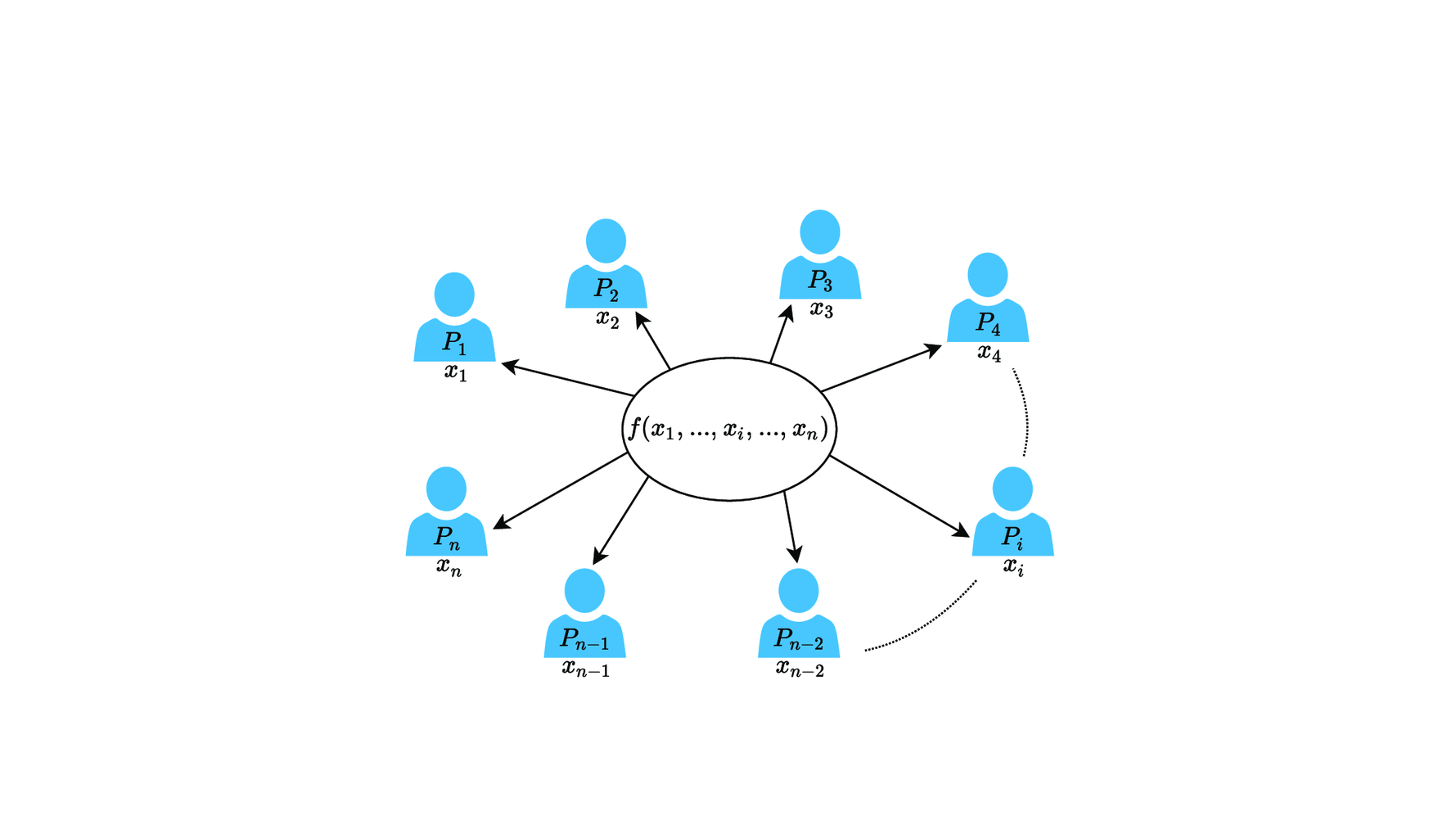

- 对于 Sensing 层面,我们用若干种不同的模型去感知,得到很多组 01 的随机变量。

- 对于 Reasoning 层面,我们把之前的若干个结果汇总,利用领域知识(domain knowledge)和概率模型去矫正和逼近真实答案。常见的概率模型有:

- 基于无向图的 Markov logic networks(MLN)

- 基于有向图的 Bayesian networks (其实就是条件概率构建在图上)

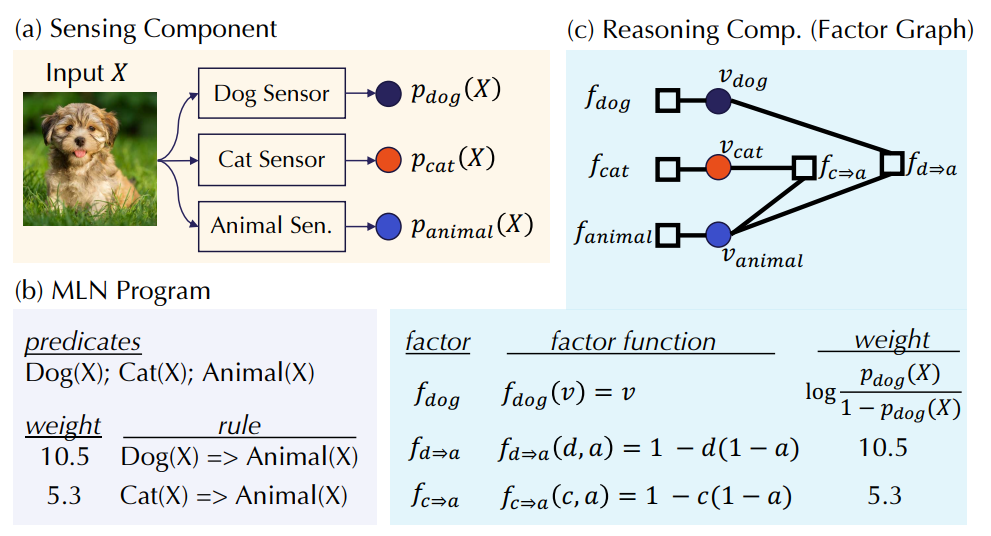

- 论文里介绍了一个有趣的例子:假设我们想判断一张图 X 的信息。

- 我们在 Sensing 层面设了 Dog Sensor,Cat Sensor 和 Animial Sensor 三个神经网络模型去感知,从而能得到三个概率 p1,p2,p3,pi 表示该图 是 物体 i 的概率。

- 由知识和经验,我们知道猫和狗都是动物,该规律可以在 Reasoning 层面帮我们去矫正之前的概率。

Markov Logic Networks

- 下面介绍一下在 Reasoning 层面下的 MLN 的标准化定义。它是一张图 (V,F) 。

- V=X∪Y 代表节点集合。

- X 是为每一个 Sensor 分别创立的点的集合,Y 是 MLN 里的其他节点集合。

- F=G∪H 代表事实集合,每个元素 f 包括权重 wf 和函数 Ff(从 V 的一个子集映射到 {0,1})

- G 对应 X 子集里每一个点的 Factor,wGi=log1−pi(X)pi(X),FGi(a)=[a=1]

- H 对应 MLN 里的其他 Factor 集合。

- 对于任何一个可能的情况,MLN 里的每一个节点都会有一个唯一的 0 或 1 的取值,我们称它为一个 possible world。更规范地来说,一个 possible world 对应一个函数 σ:V→{0,1}

- 一个 MLN 节点的最终预测由以下公式给出

- E[RMLN({pi(X)}i∈[n])]=Pr[v=1]=Z2({pi(X)}i∈[n])Z1({pi(X)}i∈[n])

- Z1({pi(X)}i∈[n])=σ∈Σ∧σ(v)=1∑exp{∑Gi∈GwGiσ(xi)+∑H∈HwHfH(σ(vH))}

- Z2({pi(X)}i∈[n])=σ∈Σ∑exp{∑Gi∈GwGiσ(xi)+∑H∈HwHfH(σ(vH))}

- 这里也可以解释为什么 G 集合里的 Factor 权重要定义为 log1−pi(X)pi(X),因为假设 H=∅,把这个式子带入预测公式,得到的答案正好是 pi(X),这是自洽、符合逻辑的。

Reasoning Robustness 的复杂性理论

- Counting Problem:给出多项式时间内可计算的权值函数 w 和询问函数 Q(相当于一个模型,比如可以用 MLN) 以及一个实数 εc>0,要 求一个Z 使得 1−εc≤Eσ∼πα[Q(σ)]Z≤1+εc

- Robustness Problem:给出多项式时间内可计算的权值函数 w 和询问函数 Q 以及两个实数 ϵ,δ>0,对于满足 ∣α−α′∣∞<ϵ 的任何扰动 α′ ,判定 是否一直有 ∣Eσ∼πα[Q(σ)]−Eσ∼πα′[Q(σ)]∣<δ 。

*Counting 到 Robustness 的规约

-

论文里证明了:COUNTING 问题可以通过询问 O(εC21) 次 规约到 ROBUSTNESS 问题。

- 我们要解决的 COUNTING 问题是:求 Eσ∼πα[Q(σ)]=Z0+Z1Z1

- 设计一个去 ROBUSTNESS 里询问的新问题,它的权重函数为 t(σ;β)=w(σ;α)exp(βQ(σ)) ,其中 w,Q 是原 COUNTING 问题的参数,α 是原分布,β 是新分布。

- 则这个新问题满足 Eσ∼τβ[Q(σ)]=Z0+eβZ1eβZ1

-

设 R=Z1Z0,我们来评估分布 β 偏差了一个 x 后函数值的变化:

- Y+(β,x)=Eσ∼τβ+x[Q(σ)]−Eσ∼τβ[Q(σ)]=Z0+exeβZ1exeβZ1−Z0+eβZ1eβZ1=R+(ex+1)eβ+Rexe2β(ex−1)eβ

- Y−(β,x)=Eσ∼τβ[Q(σ)]−Eσ∼τβ−x[Q(σ)]=Z0+eβZ1eβZ1−Z0+e−xeβZ1e−xeβZ1=exR+(ex+1)eβ+Re2β(ex−1)eβ

- 上述两式均 ≤ex/2+1ex/2−1,且在 R=eβ±x/2 时取到。

- 设 Y(β)=max{Y+(β,x),Y−(β,x)},则 Y(β) 由 eβ 和 R 的大小关系决定。

- Y 函数满足:在 [0,logR−x/2] 上升,[logR−x/2,logR] 下降,[logR,logR+ x/2] 上升, [logR+x/2,∞) 下降。

-

**我们希望用 ROBUSTNESS 的结果估计 R,这样 COUNTING 问题的答案就是 Eσ∼πα[Q(σ)]=1+R1 **

- 假设 x 是一个已知的 O(εc) 的定值

- 首先,如果分布 β 已经确定,我们可以二分 δ + 调用判定,求出误差小于 εc 的 δ,也即 Y(β) 的值。

- 我们已经知道了 Y 函数的性质,可以再套一个二分去找极大值点 β0,使得 Y(β0)≥ex/2+1ex/2−1−ε0。

- 根据一番推导,我们找到的这个 β0 满足 e−x<eβ0R<ex,这样我们便确定了 R 的范围。

- 最后我们只要设 x=log(1+εc),那么估计值 1+R1 的偏差就是 εc 了。