《数据挖掘导论》课程内容涉及机器学习入门主题,包括以下内容:

贝叶斯模型和线性分类器

非线性方法,包括 Kernel 和 神经网络

KNN,决策树和随机森林

聚类和降维

主题模型和矩阵分解

Adaboosting

贝叶斯决策理论 Bayesian Decision Theory

在 Supervised Learning 里,通过对 Samples { ( x 1 , ω 1 ) , … , ( x n , ω n } \{(x_1,\omega_1),\dots,(x_n,\omega_n\} {( x 1 , ω 1 ) , … , ( x n , ω n } x x x ω \omega ω

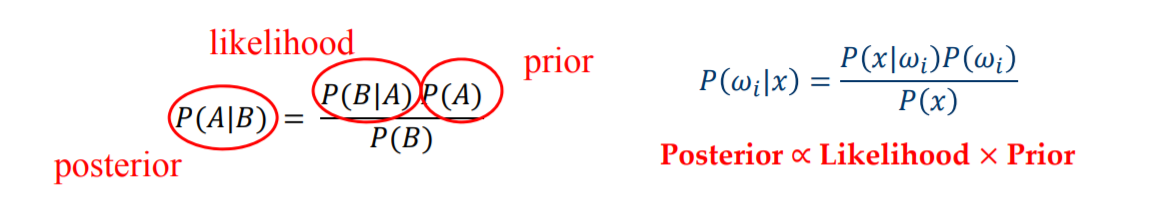

贝叶斯决策理论 (Bayesian Decision Theory ):基于贝叶斯公式进行有监督地预测。

先验 (Prior):P ( w i ) P(w_i) P ( w i ) 似然函数 (Likelihood):P ( x ∣ w i ) P(x|w_i) P ( x ∣ w i ) 后验 (Posterior):P ( w i ∣ x ) P(w_i|x) P ( w i ∣ x )

最大似然决策 (Maximum Likelihood Decision ):用 Likelihood 预测,选择 P ( x ∣ ω j ) P(x|\omega_j) P ( x ∣ ω j ) ω j \omega_j ω j

隐含了所有类别的先验概率相同,即 P ( w 1 ) = P ( w 2 ) = ⋯ = P ( w n ) P(w_1)=P(w_2)=\dots=P(w_n) P ( w 1 ) = P ( w 2 ) = ⋯ = P ( w n )

最优贝叶斯决策 (Optimal Bayes Decision Rule ):用 Posterior 去预测二分类(即选择 P ( ω j ∣ x ) P(\omega_j|x) P ( ω j ∣ x ) ω j \omega_j ω j

假设只有两个标签,则 P ( e r r o r ∣ x ) = P ( ω ∼ o ∣ x ) = min ( P ( ω 1 ∣ x ) , P ( ω 2 ∣ x ) ) P(error|x)=P(\omega_{\sim o}|x)=\min(P(\omega_1|x), P(\omega_2|x)) P ( error ∣ x ) = P ( ω ∼ o ∣ x ) = min ( P ( ω 1 ∣ x ) , P ( ω 2 ∣ x )) ω o \omega_o ω o

P ( e r r o r ) = ∫ x P ( e r r o r ∣ x ) P(error)=\int_xP(error|x) P ( error ) = ∫ x P ( error ∣ x ) min \min min

在现实情况下,我们可能会对 Loss Function 有不同的要求,所以形式化的贝叶斯估计如下:

假设总共有 { ω 1 , … , ω c } \{\omega_1,\dots,\omega_c\} { ω 1 , … , ω c } α 1 , … , α n \alpha_1,\dots,\alpha_n α 1 , … , α n

定义损失函数 λ ( α i ∣ ω i ) \lambda(\alpha_i|\omega_i) λ ( α i ∣ ω i ) ω j \omega_j ω j α i \alpha_i α i

那么 Conditional risk 就是 R ( α i ∣ x ) = ∑ j = 1 c λ ( α i ∣ ω j ) P ( ω j ∣ x ) R(\alpha_{i} | x)=\sum_{j=1}^{c} \lambda(\alpha_{i} | \omega_{j}) P(\omega_{j} | x) R ( α i ∣ x ) = ∑ j = 1 c λ ( α i ∣ ω j ) P ( ω j ∣ x )

定义 Bayes Risk 为 R R R x x x

刚才讲到的用 Posterior 去预测,其实取的就是 λ i , j = [ i = j ] \lambda_{i,j}=[i=j] λ i , j = [ i = j ]

对于 Prior 的估计,可以直接用训练集里每一种标签出现的频率。但是如何估计 Likelihood 呢?

这就涉及到 Parameter Estimation 的知识了。假设 Likelihood 的分布满足某个已知函数,我们要根据训练数据估计出这个函数的参数 θ j \theta_j θ j P ( x ∣ ω j ) P(x|\omega_j) P ( x ∣ ω j ) P ( x ∣ ω j ) ∼ N ( μ j , σ j ) P(x|\omega_j) \sim N(\mu_j,\sigma_j) P ( x ∣ ω j ) ∼ N ( μ j , σ j )

注意到,对于一个给定的标签 ω j \omega_j ω j P ( x ∣ ω j ) P(x|\omega_j) P ( x ∣ ω j ) w j w_j w j ω j \omega_j ω j n n n D = { x 1 , x 2 , … , x n } D=\{x_1,x_2,\dots,x_n\} D = { x 1 , x 2 , … , x n } P ( x ∣ ω j ) P(x|\omega_j) P ( x ∣ ω j ) P ( x ∣ D ) P(x|D) P ( x ∣ D )

参数估计主要分为两种方法:Maximum‐Likelihood 和 Bayesian Estimation 。

Maximum‐Likelihood 认为参数 θ \theta θ θ \theta θ P ( x ∣ D ) P(x|D) P ( x ∣ D ) θ ^ \hat \theta θ ^ P ( D ∣ θ ) = ∏ i = 1 n P ( x i ∣ θ ) P(D|\theta)=\prod \limits_{i=1}^nP(x_i|\theta) P ( D ∣ θ ) = i = 1 ∏ n P ( x i ∣ θ ) ( μ , σ ) (\pmb{\mu},\sigma) ( μ , σ )

回忆正态分布的矩阵表示:P ( x ) = 1 ( 2 π ) d 2 ∣ Σ ∣ 1 2 exp [ − 1 2 ( x − μ ) T Σ − 1 ( x − μ ) ] P(\boldsymbol{x})=\frac{1}{(2 \pi)^{\frac{d}{2}}|\Sigma|^{\frac{1}{2}}} \exp \left[-\frac{1}{2}(\boldsymbol{x}-\boldsymbol{\mu})^{T} \Sigma^{-1}(\boldsymbol{x}-\boldsymbol{\mu})\right] P ( x ) = ( 2 π ) 2 d ∣Σ ∣ 2 1 1 exp [ − 2 1 ( x − μ ) T Σ − 1 ( x − μ ) ]

则参数 μ \pmb{\mu} μ ln P ( x k ∣ μ ) = − 1 2 ln [ ( 2 π ) d ∣ Σ ∣ ] − 1 2 ( x k − μ ) T Σ − 1 ( x k − μ ) \ln P\left(x_{k} | \mu\right)=-\frac{1}{2} \ln \left[(2 \pi)^{d}|\Sigma|\right]-\frac{1}{2}\left(\pmb{x}_{k}-\pmb{\mu}\right)^{T} \Sigma^{-1}\left(\pmb{x}_{k}-\pmb{\mu}\right) ln P ( x k ∣ μ ) = − 2 1 ln [ ( 2 π ) d ∣Σ∣ ] − 2 1 ( x k − μ ) T Σ − 1 ( x k − μ )

导函数等于 0 0 0 μ ^ = 1 n ∑ k = 1 n x k \boldsymbol{\hat \mu}=\frac{1}{n} \sum_{k=1}^{n} x_{k} μ ^ = n 1 ∑ k = 1 n x k Σ ^ = 1 n ∑ k = 1 n ( x k − μ ^ ) ( x k − μ ^ ) t \boldsymbol{\hat \Sigma}=\frac{1}{n} \sum_{k=1}^{n}\left(\mathbf{x}_{k}-\hat{\boldsymbol{\mu}}\right)\left(\mathbf{x}_{k}-\hat{\boldsymbol{\mu}}\right)^{t} Σ ^ = n 1 ∑ k = 1 n ( x k − μ ^ ) ( x k − μ ^ ) t

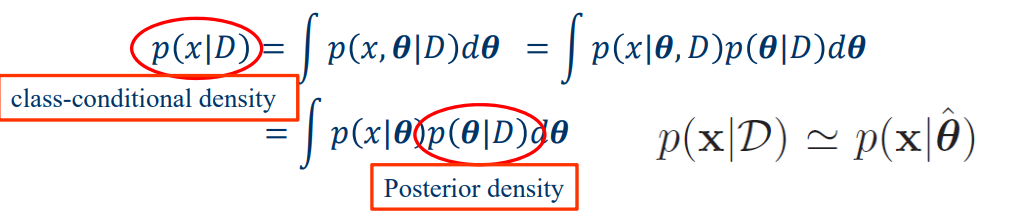

Bayesian Estimation 则是把参数 θ \theta θ P ( x ∣ D ) = ∫ θ P ( x ∣ θ ) P ( θ ∣ D ) P(x|D)=\int _\theta P(x|\theta)P(\theta|D) P ( x ∣ D ) = ∫ θ P ( x ∣ θ ) P ( θ ∣ D ) D D D θ \theta θ P ( θ ∣ D ) P(\theta|D) P ( θ ∣ D ) θ \theta θ D D D

注意到,如果 θ \theta θ θ ^ \hat \theta θ ^ P ( x ∣ D ) P(x|D) P ( x ∣ D ) P ( x ∣ θ ^ ) P(x|\hat \theta) P ( x ∣ θ ^ )

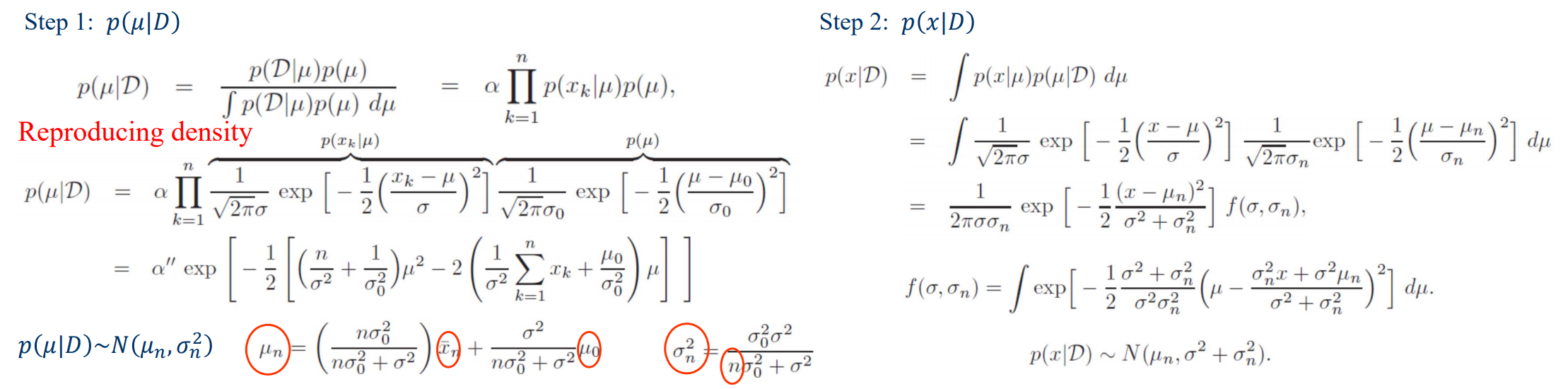

举一个理论推导的例子,假设 P ( x ∣ D ) ∼ N ( μ , σ 2 ) P(x|D) \sim N(\mu,\sigma^2) P ( x ∣ D ) ∼ N ( μ , σ 2 ) μ \mu μ N ( μ 0 , σ 0 2 ) N(\mu_0,\sigma_0^2) N ( μ 0 , σ 0 2 ) P ( θ ∣ D ) P(\theta|D) P ( θ ∣ D ) 再套一次贝叶斯公式 ,即 P ( θ ∣ D ) ∝ P ( D ∣ θ ) P ( θ ) P(\theta|D) \propto P(D|\theta)P(\theta) P ( θ ∣ D ) ∝ P ( D ∣ θ ) P ( θ )

最后总结一下解决实际问题的 Naïve Bayes Classifier 步骤。

为了预测 P ( ω ∣ x ) P(\omega|\pmb{x}) P ( ω ∣ x ) P ( ω j ) P(\omega_j) P ( ω j ) ω j \omega_j ω j j j j P ( x ∣ ω j ) P(\pmb{x}|\omega_j) P ( x ∣ ω j )

上面讨论的所有做法里,每一条数据默认只有一个特征。现实里如果有多个特征,我们可以简单地假设它们之间条件独立,即 P ( x ∣ ω j ) = ∏ P ( x i ∣ ω j ) P(\pmb{x}|\omega_j)=\prod P(x_i|\omega_j) P ( x ∣ ω j ) = ∏ P ( x i ∣ ω j )

对于离散的特征,P ( x i ∣ ω j ) P(x_i|\omega_j) P ( x i ∣ ω j ) x i x_i x i ω j \omega_j ω j

把分布函数划成离散的几段(bin),和离散的方法一样,每段统计频率。

假设它是正态分布,直接用 MLE 的结论去估计 ( μ , σ ) (\mu,\sigma) ( μ , σ ) P ( x i ∣ ω j ) P(x_i|\omega_j) P ( x i ∣ ω j )

注意:因为条件独立的假设,数据量不足时可能会因为某个特征的 P ( x i ∣ ω j ) = 0 P(x_i|\omega_j)=0 P ( x i ∣ ω j ) = 0 P ( x ∣ ω j ) P(\pmb{x}|\omega_j) P ( x ∣ ω j ) 0 0 0 Laplace smoothing ,把 P ( x i ∣ ω k ) P(x_{i} | \omega_{k}) P ( x i ∣ ω k ) ∣ x i k ∣ N ω k \frac{|x_{ik}|}{N_{\omega_k}} N ω k ∣ x ik ∣ ∣ x i k ∣ + 1 N ω k + K \frac{|x_{i k}|+1}{N_{\omega_{k}}+K} N ω k + K ∣ x ik ∣ + 1

线性模型 Linear Model

线性模型 (Linear Model ):已知训练数据 ( x i , y i ) (\pmb{x}_i,y_i) ( x i , y i ) w \pmb{w} w f ( x ) = w 0 + w T x f(x)=\pmb{w}_0+\pmb{w}^T\pmb{x} f ( x ) = w 0 + w T x

线性回归 (Linear Regression ):用均方误差(M ean S quared E rror)估价,即 J n = 1 n ∑ ( y i − f ( x i ) ) 2 J_n=\frac{1}{n} \sum (y_i-f(\pmb{x}_i))^2 J n = n 1 ∑ ( y i − f ( x i ) ) 2

X = [ x 1 , x 2 , … , x n ] , Y = [ y 1 , y 2 , … , y n ] J n ( w ) = ( Y − X T w ) T ( Y − X T w ) ∇ J n = − 2 X ( Y − X T w ) ∇ J n = 0 ↔ w ^ = ( X X T ) − 1 X Y X=[\pmb{x}_1,\pmb{x}_2,\dots,\pmb{x}_n], Y=[y_1,y_2,\dots,y_n]\\

J_n(w)=(Y-X^T\pmb{w})^T(Y-X^T\pmb{w}) \\

\nabla J_n=-2X(Y-X^T\pmb{w}) \\

\nabla J_n =0 \leftrightarrow \pmb{\hat w}=(XX^T)^{-1}XY

X = [ x 1 , x 2 , … , x n ] , Y = [ y 1 , y 2 , … , y n ] J n ( w ) = ( Y − X T w ) T ( Y − X T w ) ∇ J n = − 2 X ( Y − X T w ) ∇ J n = 0 ↔ w ^ = ( X X T ) − 1 X Y

推论:如果样本数小于特征数,X X T XX^T X X T

拓展:为什么用均方误差估价是合理的?

一个线性模型的实际效果记为 y = f ( x , w ) + ϵ y=f(\pmb{x},\pmb{w})+\epsilon y = f ( x , w ) + ϵ ϵ \epsilon ϵ N ( 0 , σ 2 ) N(0,\sigma^2) N ( 0 , σ 2 )

如果我们已经有了个模型,那么当前标签分布出现的概率是 L = ∏ i = 1 n P ( y i ∣ x i , w i , σ ) L=\prod \limits_{i=1}^n P(y_i|\pmb{x}_i,\pmb{w}_i,\sigma) L = i = 1 ∏ n P ( y i ∣ x i , w i , σ )

我们希望找到一个模型使得 L L L L L L

log L = − 1 2 σ 2 ∑ ( y − f ( x , w ) 2 ) + c ( σ ) \log L=-\frac{1}{2\sigma^2}\sum(y-f(\pmb{x},\pmb{w})^2)+c(\sigma)

log L = − 2 σ 2 1 ∑ ( y − f ( x , w ) 2 ) + c ( σ )

拓展:使用 λ ∣ w ∣ q \lambda |\pmb{w}|_q λ ∣ w ∣ q q = 1 , 2 , 3 … q=1,2,3 \dots q = 1 , 2 , 3 … q = 0.5 q=0.5 q = 0.5

岭回归 (Ridge Regression ):特指 q = 2 q=2 q = 2

J ’ n = ∑ i = 1 n ( y i − x i T w ) 2 + λ ∑ i = 1 p w j 2 ∇ J n ′ = − 2 X ( Y − X T w ) + 2 λ w ∇ J n = 0 ↔ w ^ = ( X X T + λ I ) − 1 X Y J’_n=\sum \limits_{i=1}^n(y_i-\pmb{x}_i^T\pmb{w})^2+\lambda \sum \limits_{i=1}^p \pmb{w}_j^2 \\

\nabla J'_n=-2X(Y-X^T\pmb{w})+2\lambda \pmb{w} \\

\nabla J_n =0 \leftrightarrow \pmb{\hat w}=(XX^T+\lambda\pmb{I})^{-1}XY

J ’ n = i = 1 ∑ n ( y i − x i T w ) 2 + λ i = 1 ∑ p w j 2 ∇ J n ′ = − 2 X ( Y − X T w ) + 2 λ w ∇ J n = 0 ↔ w ^ = ( X X T + λ I ) − 1 X Y

套索算法 (LASSO ):特指 q = 1 q=1 q = 1 0 0 0

逻辑回归 (Logistic Regression ):在线性变换的基础上又套了一个 Sigmoid \text{Sigmoid} Sigmoid

P ( y i = ± 1 ∣ x , a ) = 1 1 + e − y i a T x P(y_i=\pm 1|\pmb{x},\pmb{a})=\frac{1}{1+e^{-y_i\pmb{a}^T\pmb{x}}}

P ( y i = ± 1∣ x , a ) = 1 + e − y i a T x 1

由于 Sigmoid \text{Sigmoid} Sigmoid ( − ∞ , + ∞ ) (-\infty,+\infty) ( − ∞ , + ∞ ) ( 0 , 1 ) (0,1) ( 0 , 1 )

之前说的贝叶斯模型被称为 Generative Modeling (生成模型),因为该模型表示了从给定输入 X X X Y Y Y Discriminative Modeling (判别模型),它会直接学习概率分布,但是不能反映训练数据本身的特性。

现在我们想找一组参数 a \pmb{a} a

E ( a ) = ∏ i ∈ I 1 1 + e − y i a T x i E(\pmb{a})=\prod \limits_{i \in I} \frac{1}{1+e^{-y_i\pmb{a}^T\pmb{x}_i}}

E ( a ) = i ∈ I ∏ 1 + e − y i a T x i 1

当然在具体训练时,我们会对 E ( a ) E(\pmb{a}) E ( a )

ln E ( a ) = ∑ i ∈ I ln ( 1 + e − y i a T x i ) \ln E(\pmb{a})=\sum \limits_{i \in I} \ln (1+e^{-y_i\pmb{a}^T\pmb{x}_i})

ln E ( a ) = i ∈ I ∑ ln ( 1 + e − y i a T x i )

下面我们来简要证明 ln E ( a ) \ln E(\pmb{a}) ln E ( a )

先把 ∑ \sum ∑

设 θ i = a T x i \theta_i=\pmb{a}^T\pmb{x}_i θ i = a T x i ln E ( a ) \ln E(\pmb{a}) ln E ( a ) ln E ( θ i ) \ln E(\theta_i) ln E ( θ i )

所以我们现在想证明 J ( θ ) = ln ( 1 + e − y i θ ) J(\theta)=\ln(1+e^{-y_i\theta}) J ( θ ) = ln ( 1 + e − y i θ )

求一阶导 J ′ ( θ ) = − y i e y i θ + 1 J'(\theta)=-\frac{y_i}{e^{y_i\theta}+1} J ′ ( θ ) = − e y i θ + 1 y i J ′ ′ ( θ ) = e y i θ ( e y i θ + 1 ) 2 = e θ ( e θ + 1 ) 2 ≥ 0 J''(\theta)=\frac{e^{y_i\theta}}{(e^{y_i\theta}+1)^2}=\frac{e^\theta}{(e^\theta+1)^2} \ge 0 J ′′ ( θ ) = ( e y i θ + 1 ) 2 e y i θ = ( e θ + 1 ) 2 e θ ≥ 0

所以 J ( θ i ) J(\theta_i) J ( θ i ) ln E ( a ) \ln E(\pmb{a}) ln E ( a )

模型评估 Model Assessment and Selection

Bias & Variance Decomposition 是模型评价的理论基石。

对于有一个有监督学习 ( x i , y i ) (\pmb{x}_i,y_i) ( x i , y i ) f ( x ) f(\pmb{x}) f ( x )

E ( L ) = ∬ L ( y , f ( x ) ) p ( x , y ) d x d y E(L)=\iint L(y,f(\pmb{x}))~p(\pmb{x},y) d\pmb{x}dy

E ( L ) = ∬ L ( y , f ( x )) p ( x , y ) d x d y

假设损失函数使用平方误差,那么得到的 Expected Prediction Error 是:

E P E ( f ) = ∬ ( y − f ( x ) ) 2 p ( x , y ) d x d y EPE(f)=\iint (y-f(\pmb{x}))^2~p(\pmb{x},y)dxdy

EPE ( f ) = ∬ ( y − f ( x ) ) 2 p ( x , y ) d x d y

现在我们想化简这个积分式。把 ( y − f ( x ) ) 2 (y-f(\pmb{x}))^2 ( y − f ( x ) ) 2 ( y − E ( y ∣ x ) + E ( y ∣ x ) − f ( x ) ) 2 (y-E(y|\pmb{x})+E(y|\pmb{x})-f(\pmb{x}))^2 ( y − E ( y ∣ x ) + E ( y ∣ x ) − f ( x ) ) 2

E P E ( f ) = ∫ ( f ( x ) − E ( y ∣ x ) ) 2 p ( x ) d x + ∫ v a r ( y ∣ x ) p ( x ) d x EPE(f)=\int (f(\pmb{x})-E(y|\pmb{x}))^2p(\pmb{x})d\pmb{x} + \int var(y|\pmb{x})p(\pmb{x})d\pmb{x}

EPE ( f ) = ∫ ( f ( x ) − E ( y ∣ x ) ) 2 p ( x ) d x + ∫ v a r ( y ∣ x ) p ( x ) d x

我们会发现,无论我们怎么选择模型都不可能让 EPE 变为 0 0 0

虽然最优的 f ( x ) f(\pmb{x}) f ( x ) f ( x ) = E ( y ∣ x ) f(\pmb{x})=E(y|\pmb{x}) f ( x ) = E ( y ∣ x ) f ( x ) f(\pmb{x}) f ( x ) f ( x ∣ D ) f(\pmb{x}|D) f ( x ∣ D )

bias = ∫ { E D ( f ( x ; D ) − E ( y ∣ x ) ) } 2 p ( x ) d x variance = ∫ E D { [ f ( x ; D ) − E D ( x ; D ) ] 2 } p ( x ) d x noise = ∫ v a r ( y ∣ x ) p ( x ) d x \begin{align}

\text{bias} &= \int \{E_D(f(\pmb{x};D)-E(y|\pmb{x}))\}^2p(\pmb{x})d\pmb{x} \\

\text{variance} &= \int E_D\{[f(\pmb{x};D)-E_D(\pmb{x};D)]^2\}p(\pmb{x})d\pmb{x} \\

\text{noise} &= \int var(y|\pmb{x})p(\pmb{x})d\pmb{x}

\end{align}

bias variance noise = ∫ { E D ( f ( x ; D ) − E ( y ∣ x )) } 2 p ( x ) d x = ∫ E D {[ f ( x ; D ) − E D ( x ; D ) ] 2 } p ( x ) d x = ∫ v a r ( y ∣ x ) p ( x ) d x

之前说的正则化操作,大的 λ \lambda λ λ \lambda λ

在模型选择时,常用 Cross-Validation 的方法。将训练数据集划成 k k k i i i k − 1 k-1 k − 1 k k k k = N k=N k = N

决策树 Decision Tree

决策树 (Decision Tree )是一个简单而有效的分类问题的解决方案。训练时,它每次从当前(带标签的)样本中选择一个“方差”最大的属性 a a a

熵 (entropy )是随机变量不确定性的度量。设 E E E P ( X = x k ) = p k P(X=x_k) = p_k P ( X = x k ) = p k

E n t ( E ) = − ∑ k = 1 K p k log ( p k ) Ent(E)=-\sum \limits_{k=1}^{K} p_k\log(p_k)

E n t ( E ) = − k = 1 ∑ K p k log ( p k )

E n t Ent E n t E E E lim p → 0 + p k log ( p k ) = 0 \lim \limits_{p\to 0^+} p_k\log(p_k)=0 p → 0 + lim p k log ( p k ) = 0 0 log 0 = 0 0 \log 0=0 0 log 0 = 0

我们尝试把熵应用到决策树的属性选择上。对于样本 D D D K K K n 0 n_0 n 0 n 1 … n k n_1 \dots n_k n 1 … n k D D D H ( D ) H(D) H ( D )

H ( D ) = − ∑ k = 1 K n k n 0 log ( n k n 0 ) H(D)=-\sum \limits_{k=1}^{K} \frac{n_k}{n_0}\log(\frac{n_k}{n_0})

H ( D ) = − k = 1 ∑ K n 0 n k log ( n 0 n k )

H ( D ) H(D) H ( D )

如果样本 D D D a a a V V V a a a D D D 信息增益 :

g ( D , a ) = H ( D ) − ∑ v = 1 V ∣ D v ∣ ∣ D ∣ H ( D v ) g(D,a)=H(D)-\sum \limits_{v=1}^V \frac{|D_v|}{|D|}H(D_v)

g ( D , a ) = H ( D ) − v = 1 ∑ V ∣ D ∣ ∣ D v ∣ H ( D v )

显然,g ( D , a ) g(D,a) g ( D , a ) a a a ID3 决策树 就是靠这个决定属性的。注意,该准则对可取值数目较多的属性有所偏好,这种偏好可能带来不良影响。

为了改进上述问题,C4.5算法 引入了 信息增益率 的新准则。

g R ( D , a ) = g ( D , a ) H a ( D ) g_R(D,a)=\frac{g(D,a)}{H_a(D)}

g R ( D , a ) = H a ( D ) g ( D , a )

这里的 H a ( D ) H_a(D) H a ( D ) H ( D ) H(D) H ( D ) H ( D ) H(D) H ( D ) H a ( D ) H_a(D) H a ( D ) a a a H a ( D ) H_a(D) H a ( D ) H ( a ) H(a) H ( a )

此外,CART 算法 用 基尼不纯度 (gini impurity) 来构建决策树的划分函数。基尼指数就是独立取值两次后不相等的概率。设 E E E P ( X = x k ) = p k P(X=x_k) = p_k P ( X = x k ) = p k

I ( E ) = ∑ k = 1 K p i ∑ k ≠ i p k = 1 − ∑ k = 1 K p k 2 I(E)=\sum \limits_{k=1}^K p_i \sum \limits_{k \ne i}p_k=1-\sum \limits_{k=1}^K p_k^2

I ( E ) = k = 1 ∑ K p i k = i ∑ p k = 1 − k = 1 ∑ K p k 2

推广到决策树,定义属性 a a a D D D

g I ( D , a ) = I ( D ) − ∑ v = 1 V ∣ D v ∣ ∣ D ∣ I ( D v ) g_I(D,a)=I(D)-\sum \limits_{v=1}^V \frac{|D_v|}{|D|}I(D_v)

g I ( D , a ) = I ( D ) − v = 1 ∑ V ∣ D ∣ ∣ D v ∣ I ( D v )

更加优美的是:基尼不纯度增益 和 信息熵增益 还有神秘的联系!当 p p p log ( p ) ∼ p − 1 \log(p) \sim p-1 log ( p ) ∼ p − 1 − p log p ∼ p ( 1 − p ) -p \log p \sim p(1-p) − p log p ∼ p ( 1 − p )

单一的决策树往往会遇到过拟合的问题。所以我们往往会留下一部分数据作为 Validation,同时在构建决策树时利用它们做一些 剪枝 。下面是两个有效的剪枝技巧:

Prepruning 预剪枝:在某个点决定完分支后,我们把 Validation 的数据分别用不分支(即直接在这个点投票决定统一的预测)和分支验证一遍。如果前者优于后者,我们就在这个节点进行剪枝。

Postpruning 后剪枝:我们先建好整棵搜索树,在回溯的时候同时维护当前子树的 Validation 结果。如果某个点直接投票的答案优于产生分支的答案(即子树结果和),我们就在这个节点进行剪枝。

预剪枝的剪枝本身带有估计的成分(因为下一层其实还没有继续分叉),剪枝力度往往很大;实际中一般会采取比较稳定的后剪枝方法。下面是我对 Titanic 数据集进行决策树剪枝的实验结果:

方法

总运行时间 s

平均节点

平均训练集正确率 %

平均测试集正确率 %

No pruning 3.85

217.7

86.11

79.43

Prepruning 1.84

14.6

79.88

78.47

Postpruning 2.91

44.4

81.87

80.76

集成模型 Ensemble Model

我们通常用 committee 来形容多个模型集成的方法。首先来证明一下集成模型的有效性。

假设 h ( x ) h(x) h ( x ) y m ( x ) y_m(x) y m ( x ) y c o m = 1 M y m ( x ) y_{com}=\frac{1}{M}y_m(x) y co m = M 1 y m ( x )

(这里待续…)

那么如何来科学地生成 M M M

Bagging (B ootstrap Agg regating ):通过采样多组数据构建不同的模型。这些 Base Learners 之间需要略微不同,且允许有过拟合的现象发生。Bagging 分为以下两个阶段:

Bootstrap Sampling :每次从 N N N D D D Aggregating :每一个模型都训练一套参数,并把它们的预测结果聚合起来。

Boosting :通过修改每组数据的权重来构建不同的模型。

决策树是一个很好的 Base Learner,而用决策树来 Bagging 的方法被称为 随机森林(Random Forest) 。为了保证每次构建的决策树之间有更多的特异性,在每次决定分支时,我们往往先在总特征 F F F f f f f f f ∣ f ∣ = ∣ F ∣ |f|=\sqrt{|F|} ∣ f ∣ = ∣ F ∣ ∣ f ∣ = ∣ F ∣ / 3 |f|=|F|/3 ∣ f ∣ = ∣ F ∣/3

AdaBoost 全称 Adaptive Boosting ,是 Boosting 最经典的实践。首先我们先介绍它的流程。

有 n n n { ( x 1 , y 1 ) , … , ( x n , y n ) } \{(x_1,y_1),\dots,(x_n,y_n)\} {( x 1 , y 1 ) , … , ( x n , y n )} y i ∈ { − 1 , 1 } y_i \in \{-1, 1\} y i ∈ { − 1 , 1 }

最开始设参数组 w i 1 = 1 w^1_i=1 w i 1 = 1 w i m w^m_i w i m m m m

按顺序迭代 T T T m m m

训练一个分类器 g m ( x ) g_m(x) g m ( x ) ϵ m = min ∑ w i m [ g m ( x i ) ≠ y i ] \epsilon_m=\min \sum w^m_i [g_m(x_i)\ne y_i] ϵ m = min ∑ w i m [ g m ( x i ) = y i ]

设第 m m m α m = 1 2 ln ( 1 − ϵ m ϵ m ) \alpha_m=\frac{1}{2}\ln(\frac{1-\epsilon_m}{\epsilon_m}) α m = 2 1 ln ( ϵ m 1 − ϵ m ) F m ( x ) = F m − 1 ( x ) + α m g m ( x ) F_m(x)=F_{m-1}(x)+\alpha_mg_m(x) F m ( x ) = F m − 1 ( x ) + α m g m ( x )

更新下一轮样本权值,w i m + 1 = w i m exp ( − y i α m g m ( x i ) ) w^{m+1}_i=w^m_i\exp(-y_i\alpha_mg_m(x_i)) w i m + 1 = w i m exp ( − y i α m g m ( x i ))

F T ( x ) F_T(x) F T ( x ) w i m w^m_i w i m

下面我们来说明,为什么 AdaBoost 的流程是这样的,里面的函数是如何推出来的。

设 E m = ∑ exp ( − y i F m ( x i ) ) E_m=\sum \exp(-y_iF_m(x_i)) E m = ∑ exp ( − y i F m ( x i )) F m ( x ) = F m − 1 ( x ) + α m g m ( x ) F_m(x)=F_{m-1}(x)+\alpha_mg_m(x) F m ( x ) = F m − 1 ( x ) + α m g m ( x ) w i m , α m w^m_i,\alpha_m w i m , α m g m ( x ) g_m(x) g m ( x ) F m ( x ) F_m(x) F m ( x )

E m = ∑ i = 1 n exp ( − y i F m ( x i ) ) = ∑ i = 1 n exp ( − y i F m − 1 ( x i ) ) ⋅ exp ( − y i α m g m ( x i ) ) E_m=\sum \limits_{i=1}^n \exp(-y_iF_m(x_i))=\sum \limits_{i=1}^n \exp(-y_iF_{m-1}(x_i)) \cdot \exp(-y_i\alpha_mg_m(x_i))

E m = i = 1 ∑ n exp ( − y i F m ( x i )) = i = 1 ∑ n exp ( − y i F m − 1 ( x i )) ⋅ exp ( − y i α m g m ( x i ))

所以我们设 $$w^m_i=\exp(-y_i\alpha_mg_m(x_i))$$ 来简化 E m E_m E m

E m = ∑ i = 1 n w i m exp ( − y i α m g m ( x i ) ) = ∑ y i = g m ( x i ) w i m exp ( − α m ) + ∑ y i ≠ g m ( x i ) w i m exp ( α m ) ( 1 ) = ∑ i = 1 n w i m exp ( − α m ) + ∑ y i ≠ g m ( x i ) w i m ( exp ( α m ) − exp ( − α m ) ) ( 2 ) \begin{align}

E_m&=\sum \limits_{i=1}^n w^m_i\exp(-y_i\alpha_mg_m(x_i)) \quad\\

&=\sum \limits_{y_i = g_m(x_i)}w^m_i\exp(-\alpha_m)+\sum \limits_{y_i \ne g_m(x_i)}w^m_i\exp(\alpha_m) \quad (1)\\

&=\sum \limits_{i=1}^nw^m_i\exp(-\alpha_m)+\sum \limits_{y_i \ne g_m(x_i)}w^m_i(\exp(\alpha_m)-\exp(-\alpha_m)) \quad (2)

\end{align}

E m = i = 1 ∑ n w i m exp ( − y i α m g m ( x i )) = y i = g m ( x i ) ∑ w i m exp ( − α m ) + y i = g m ( x i ) ∑ w i m exp ( α m ) ( 1 ) = i = 1 ∑ n w i m exp ( − α m ) + y i = g m ( x i ) ∑ w i m ( exp ( α m ) − exp ( − α m )) ( 2 )

对于公式1,我们把 g m ( x i ) g_m(x_i) g m ( x i ) w i m w^m_i w i m E m E_m E m α m \alpha_m α m α m \alpha_m α m

d E m / d α m = 0 ∑ y i = g m ( x i ) w i m exp ( − α m ) = ∑ y i ≠ g m ( x i ) w i m exp ( α m ) − α m + ln ( ∑ y i = g m ( x i ) w i m ) = α m + ln ( ∑ y i ≠ g m ( x i ) w i m ) α m = 1 2 ln ( ∑ y i ≠ g m ( x i ) w i m ∑ y i = g m ( x i ) w i m ) \begin{align}

dE_m/d\alpha_m&=0 \\

\sum_{y_i = g_m(x_i)}w^m_i\exp(-\alpha_m)&=\sum_{y_i \ne g_m(x_i)}w^m_i\exp(\alpha_m) \\

-\alpha_m+\ln(\sum_{y_i = g_m(x_i)}w^m_i)&=\alpha_m+\ln(\sum_{y_i \ne g_m(x_i)}w^m_i) \\

\alpha_m&=\frac{1}{2}\ln(\frac{\sum_{y_i \ne g_m(x_i)}w^m_i}{\sum_{y_i = g_m(x_i)}w^m_i})

\end{align}

d E m / d α m y i = g m ( x i ) ∑ w i m exp ( − α m ) − α m + ln ( y i = g m ( x i ) ∑ w i m ) α m = 0 = y i = g m ( x i ) ∑ w i m exp ( α m ) = α m + ln ( y i = g m ( x i ) ∑ w i m ) = 2 1 ln ( ∑ y i = g m ( x i ) w i m ∑ y i = g m ( x i ) w i m )

对于公式2,我们把 α m \alpha_m α m w i m w^m_i w i m ∑ y i ≠ g m ( x i ) w i m \sum \limits_{y_i \ne g_m(x_i)}w^m_i y i = g m ( x i ) ∑ w i m g m ( x ) g_m(x) g m ( x )

以上分析摘自 Wikipedia 有关 AdaBoost 的介绍 ,下面再引入一个蔡登教授课程中的推导角度。

我们用另一个角度来解释 w i m w^m_i w i m g m ( x ) g_m(x) g m ( x ) g m ( x ) g_m(x) g m ( x ) ∑ i = 1 n w i m [ g m ( i ) ≠ y i ] \sum_{i=1}^n w^m_i [g_m(i) \ne y_i] ∑ i = 1 n w i m [ g m ( i ) = y i ] g m + 1 ( x ) g_{m+1}(x) g m + 1 ( x ) g m ( x ) g_m(x) g m ( x ) w i m + 1 w^{m+1}_i w i m + 1 g m ( x ) g_m(x) g m ( x ) g m + 1 ( x ) g_{m+1}(x) g m + 1 ( x ) w i m + 1 w^{m+1}_i w i m + 1 g m ( x ) g_m(x) g m ( x ) w i m + 1 w^{m+1}_i w i m + 1 50 % 50\% 50%

∑ i = 1 n w i m + 1 [ g m ( i ) ≠ y i ] ∑ i = 1 n w i m + 1 [ g m ( i ) ≠ y i ] + ∑ i = 1 n w i m + 1 [ g m ( i ) = y i ] = 1 2 \frac{\sum_{i=1}^n w^{m+1}_i[g_m(i) \ne y_i]}{\sum_{i=1}^n w^{m+1}_i[g_m(i) \ne y_i]+\sum_{i=1}^n w^{m+1}_i[g_m(i) = y_i]}=\frac{1}{2}

∑ i = 1 n w i m + 1 [ g m ( i ) = y i ] + ∑ i = 1 n w i m + 1 [ g m ( i ) = y i ] ∑ i = 1 n w i m + 1 [ g m ( i ) = y i ] = 2 1

大部分情况下 ∑ i = 1 n w i m [ g m ( i ) ≠ y i ] \sum_{i=1}^n w^m_i [g_m(i) \ne y_i] ∑ i = 1 n w i m [ g m ( i ) = y i ] g m ( i ) ≠ y i g_m(i) \ne y_i g m ( i ) = y i w i m + 1 w^{m+1}_i w i m + 1 50 % 50\% 50% g m + 1 ( x ) g_{m+1}(x) g m + 1 ( x ) w i m + 1 = w i m exp ( − y i α m g m ( x i ) ) w^{m+1}_i=w^{m}_i\exp(-y_i\alpha_mg_m(x_i)) w i m + 1 = w i m exp ( − y i α m g m ( x i )) α m = 1 2 ln ( 1 − ϵ m ϵ m ) \alpha_m=\frac{1}{2}\ln(\frac{1-\epsilon_m}{\epsilon_m}) α m = 2 1 ln ( ϵ m 1 − ϵ m )

主题模型 Topic Model

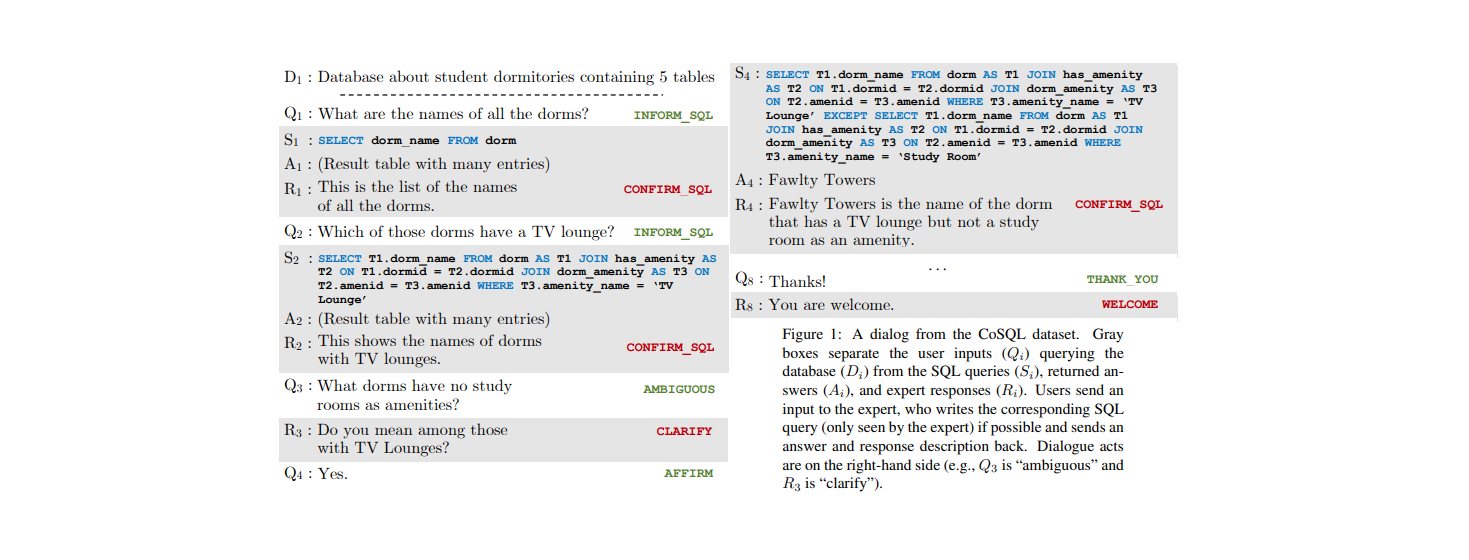

主题模型多用于文本分析,比如判断一篇文档的主题。或者说给出一个文档集合和一些 queries,每次要回答与当前 query 最相近的页面(搜索引擎)。

注意,我们在这里探讨的主题模型属于 Bag‐of‐Words(词袋模型),即我们不考虑单词出现的顺序问题,只考虑整篇文档里单词的概率分布。这样可以简化问题。

一个最直接的做法是 Salton’s Vector Space Model 。对于每一个文档,统计各个单词出现的次数,并用一个向量去描述它——该向量的长度就是字典大小。我们可以开一个 w e i g h t weight w e i g h t

这样做有什么问题呢?topics 和 words 之间可能会存在不匹配的现象!

一词多义会让两个远离向量的距离变小

同义词会让两个相近向量的距离变大

在 Language Model Paradigm 里,我们应用贝叶斯公式去完成文档查询。设 R d ∈ { 0 , 1 } R_d \in \{0,1\} R d ∈ { 0 , 1 } d d d q q q P ( R d = 1 ∣ q ) ∝ P ( q ∣ R d = 1 ) P ( R d = 1 ) P(R_d=1|q) \propto P(q|R_d=1)P(R_d=1) P ( R d = 1∣ q ) ∝ P ( q ∣ R d = 1 ) P ( R d = 1 )

Prior P ( R d = 1 ) P(R_d=1) P ( R d = 1 ) Page Rank 。

Likelihood P ( q ∣ R d = 1 ) P(q|R_d=1) P ( q ∣ R d = 1 )

一次询问 q q q q = ( w 1 , w 2 , … , w q ) q=(w_1,w_2,\dots,w_q) q = ( w 1 , w 2 , … , w q ) P ( q ∣ R d = 1 ) = ∏ w ∈ q P ( w ∣ d ) P(q|R_d=1)=\prod \limits_{w \in q}P(w|d) P ( q ∣ R d = 1 ) = w ∈ q ∏ P ( w ∣ d ) P ( w ∣ d ) P(w|d) P ( w ∣ d )

一个 Naive 的尝试是:取 P ^ ( w ∣ d ) = n ( d , w ) ∑ w ′ n ( d , w ′ ) \hat P(w|d)=\frac{n(d,w)}{\sum _{w'} n(d,w')} P ^ ( w ∣ d ) = ∑ w ′ n ( d , w ′ ) n ( d , w )

下面介绍一下经典的 Probabilistic Latent Semantic Analysis 方法。在 Document 和 Vocabulary 之间添加一个新的关系 Topic。我们认为一篇文档里的 n n n z z z w w w P ( w ∣ d ) = ∑ z P ( w ∣ z ) P ( z ∣ d ) P(w|d)=\sum \limits_z{P(w|z)P(z|d)} P ( w ∣ d ) = z ∑ P ( w ∣ z ) P ( z ∣ d )

这样做有什么好处呢?本来我们需要求一个 N × M N \times M N × M i i i j j j K K K N × K N \times K N × K K × M K \times M K × M

考虑用最大似然估计去求参数。对于一篇文档,当前单词集合出现的概率是:

P ( w ∣ d ) = ∑ z P ( w ∣ z ; θ ) P ( z ∣ d ; π ) P(w|d)=\sum \limits_{z} P(w|z;\theta)P(z|d;\pi)

P ( w ∣ d ) = z ∑ P ( w ∣ z ; θ ) P ( z ∣ d ; π )

我们需要估计参数 θ \theta θ π \pi π

l ( θ , π ; N ) = ∑ d , w n ( d , w ) log ( ∑ z = 1 K P ( w ∣ z ; θ ) P ( z ∣ d ; π ) ) l(\theta,\pi;N)=\sum \limits_{d,w}n(d,w)\log(\sum \limits_{z=1}^K P(w|z;\theta)P(z|d;\pi))

l ( θ , π ; N ) = d , w ∑ n ( d , w ) log ( z = 1 ∑ K P ( w ∣ z ; θ ) P ( z ∣ d ; π ))

注意这个 l ( θ , π ; N ) l(\theta,\pi;N) l ( θ , π ; N ) Expectation Maximization 方法来求、EM 算法采用迭代的方式,专门用来求解包含“隐含变量”或者“缺失数据”的概率模型参数估计问题。

首先我们要明白,估计参数 θ \theta θ π \pi π N × K N\times K N × K K × M K \times M K × M

E-step :我们可以利用当前的结果计算最新的后验:

P ( z k ∣ d i , w j ) = P ( w j ∣ z k ) P ( z k ∣ d i ) ∑ l = 1 K P ( w j ∣ z l ) P ( z l ∣ d i ) P\left(z_{k} | d_{i}, w_{j}\right)=\frac{P\left(w_{j} | z_{k}\right) P\left(z_{k} | d_{i}\right)}{\sum_{l=1}^{K} P\left(w_{j} | z_{l}\right) P\left(z_{l} | d_{i}\right)}

P ( z k ∣ d i , w j ) = ∑ l = 1 K P ( w j ∣ z l ) P ( z l ∣ d i ) P ( w j ∣ z k ) P ( z k ∣ d i )

M-step

利用这些后验概率修正最大化函数。

E ( d i , w j , z k ) = ∑ i = 1 N ∑ j = 1 M n ( d i , w j ) ∑ k = 1 K P ( z k ∣ d i , w j ) log [ P ( w j ∣ z k ) P ( z k ∣ d i ) ] s.t. ∑ j = 1 M p ( w j ∣ z k ) = 1 , ∑ k = 1 K p ( z k ∣ d i ) = 1 E(d_i,w_j,z_k)=\sum_{i=1}^{N} \sum_{j=1}^{M} n\left(d_{i}, w_{j}\right) \sum_{k=1}^{K} P\left(z_{k} | d_{i}, w_{j}\right) \log \left[P\left(w_{j} | z_{k}\right) P\left(z_{k} | d_{i}\right)\right] \\

\text{s.t.}

\sum_{j=1}^{M} p\left(w_{j} | z_{k}\right)=1,\sum_{k=1}^{K} p\left(z_{k} | d_{i}\right)=1

E ( d i , w j , z k ) = i = 1 ∑ N j = 1 ∑ M n ( d i , w j ) k = 1 ∑ K P ( z k ∣ d i , w j ) log [ P ( w j ∣ z k ) P ( z k ∣ d i ) ] s.t. j = 1 ∑ M p ( w j ∣ z k ) = 1 , k = 1 ∑ K p ( z k ∣ d i ) = 1

用拉格朗日乘子法,拉格朗日函数为:

H = E ( d i , w j , z k ) + ∑ k = 1 K τ k ( 1 − ∑ j = 1 M P ( w j ∣ z k ) ) + ∑ i = 1 N ρ i ( 1 − ∑ k = 1 K P ( z k ∣ d i ) ) \mathcal{H}=E(d_i,w_j,z_k)+\sum_{k=1}^{K} \tau_{k}\left(1-\sum_{j=1}^{M} P\left(w_{j} | z_{k}\right)\right)+\sum_{i=1}^{N} \rho_{i}\left(1-\sum_{k=1}^{K} P\left(z_{k} | d_{i}\right)\right)

H = E ( d i , w j , z k ) + k = 1 ∑ K τ k ( 1 − j = 1 ∑ M P ( w j ∣ z k ) ) + i = 1 ∑ N ρ i ( 1 − k = 1 ∑ K P ( z k ∣ d i ) )

对 N K + M K NK+MK N K + M K

∑ i = 1 N n ( d i , w j ) P ( z k ∣ d i , w j ) − α k P ( w j ∣ z k ) = 0 ∑ j = 1 M n ( d i , w j ) P ( z k ∣ d i , w j ) − β i P ( z k ∣ d i ) = 0 \begin{align}

\sum_{i=1}^{N} n\left(d_{i}, w_{j}\right) P\left(z_{k} | d_{i}, w_{j}\right)-\alpha_{k} P\left(w_{j} | z_{k}\right)&=0\\

\sum_{j=1}^{M} n\left(d_{i}, w_{j}\right) P\left(z_{k} | d_{i}, w_{j}\right)-\beta_{i} P\left(z_{k} | d_{i}\right)&=0

\end{align}

i = 1 ∑ N n ( d i , w j ) P ( z k ∣ d i , w j ) − α k P ( w j ∣ z k ) j = 1 ∑ M n ( d i , w j ) P ( z k ∣ d i , w j ) − β i P ( z k ∣ d i ) = 0 = 0

最终解得新的迭代方程为:

P ( w j ∣ z k ) = ∑ i = 1 N n ( d i , w j ) P ( z k ∣ d i , w j ) ∑ m = 1 M ∑ i = 1 N n ( d i , w m ) P ( z k ∣ d i , w m ) P ( z k ∣ d i ) = ∑ j = 1 M n ( d i , w j ) P ( z k ∣ d i , w j ) n ( d i ) \begin{array}{l}P\left(w_{j} | z_{k}\right)=\frac{\sum_{i=1}^{N} n\left(d_{i}, w_{j}\right) P\left(z_{k} | d_{i}, w_{j}\right)}{\sum_{m=1}^{M} \sum_{i=1}^{N} n\left(d_{i}, w_{m}\right) P\left(z_{k} | d_{i}, w_{m}\right)} \\P\left(z_{k} | d_{i}\right)=\frac{\sum_{j=1}^{M} n\left(d_{i}, w_{j}\right) P\left(z_{k} | d_{i}, w_{j}\right)}{n\left(d_{i}\right)}\end{array}

P ( w j ∣ z k ) = ∑ m = 1 M ∑ i = 1 N n ( d i , w m ) P ( z k ∣ d i , w m ) ∑ i = 1 N n ( d i , w j ) P ( z k ∣ d i , w j ) P ( z k ∣ d i ) = n ( d i ) ∑ j = 1 M n ( d i , w j ) P ( z k ∣ d i , w j )